电气学院智能决策与控制技术研究团队依托学校控制科学与工程一级学科,根据国家中长期发展规划、行业需求及未来科技发展趋势,研究定位于机器人智能决策与控制领域,目前专注于具身智能操控技术(感知与认知、决策、控制、执行)的理论与应用研究。近期,智能决策与控制技术研究团队在具身智能感知与认知研究方面取得系列成果,研究成果均以我校为第一单位发表在人工智能及工程技术领域知名期刊上。

具身智能强调智能体在物理世界中身体与环境之间的交互,这种交互包含感知与认知两个关键任务。感知是具身智能系统最基本的功能之一,其感知机制通常涉及多种传感器的融合,包括视觉、触觉、听觉和运动传感器等,通过这些传感器,智能体能够实时感知环境,对其状态进行动态评估。而认知则是指智能体在感知的基础上,对获取的信息进行理解和处理,从而做出决策和行动的能力。

在追求更高层次智能的过程中,具身智能需要通过多模态信息融合机制整合来自多个感知渠道的信息,以全面理解周围环境和操作对象。目前,大多数多模态感知研究集中在基于视觉的融合上,且大多仅涉及两种模态的融合,而三种或更多模态的融合则鲜有探索。

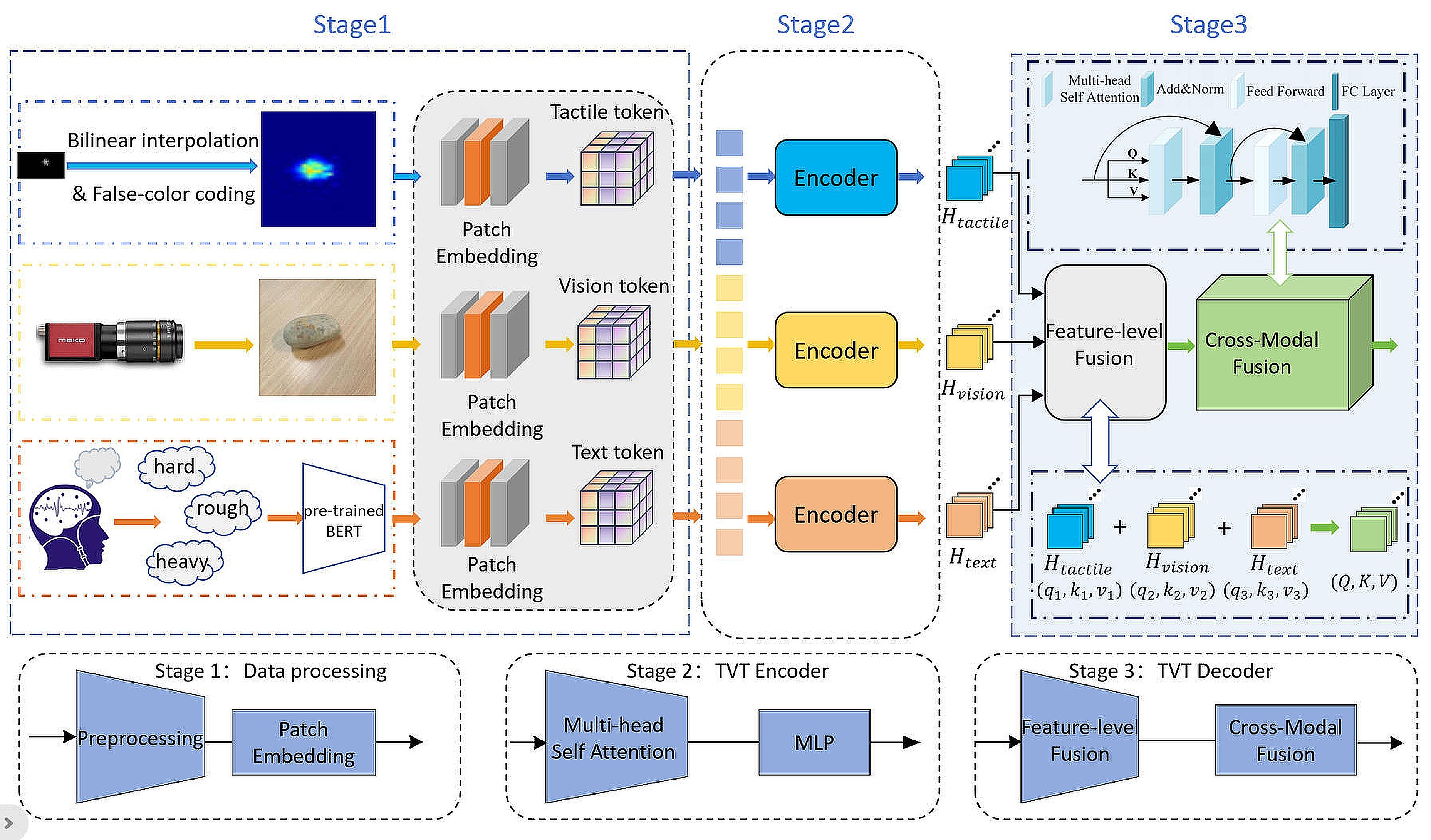

针对这一问题,研究团队提出了TVT-Transformer(Tactile-Visual-Textual:触觉-视觉-文本)这一新框架,用于从触觉、视觉和语义文本三种模态数据中联合学习。该方法利用注意力机制深入挖掘和对齐来自不同感知模态的信息,使模型能够有效地整合触觉、视觉和语义文本数据的特征,通过跨模态交互实现更深层次的信息融合。

相关研究成果以“TVT-Transformer: A Tactile-Visual-Textual Fusion Network for Object Recognition”为题,发表在人工智能领域知名期刊《Information Fusion》(IF 14.8,中国科学院一区,Top期刊)上。

该框架引入了一种新颖的语义表征方法,通过结合人类对物体的观察和触摸感知,生成标准化的语义描述并利用预训练进行编码,将语义文本与视觉和触觉信息对齐,然后将触觉、视觉和文本模态整合到一个统一的矩阵中,随后利用注意力机制进行跨注意力计算,从而实现更准确、高效的跨模态特征整合与理解。文本模态提供了语义支持,增强了信息的整合效果和对象识别的准确性。这种方法增强了特征表达能力,在多模态数据整合方面实现了显著的性能提升,并提高了对象识别的准确性。

本研究不仅为多模态信息融合领域提供了新的视角,还为具身智能的发展提供了强有力的技术支持。TVT-Transformer框架具有广泛的应用潜力,未来有望在智能机器人、人机交互和辅助决策等领域发挥重要作用。

论文链接:https://linkinghub.elsevier.com/retrieve/pii/S1566253525000168

大脑是一个由神经元、局部回路和功能区组成的复杂系统。神经通路连接不同的区域并协作完成复杂的认知和行为功能。EEGNet被认为是一种非常成功的基于卷积网络的融合脑电图(EEG)信号解码模型。但是有两点可以改进:首先,激活的大脑区域可能因不同的BCI任务而异;其次,高密度脑电图信号有可能提供更丰富的大脑信息。目前的大多数研究只是将来自不同通道的EEG信号叠加在一起,忽略了脑模型上EEG电极的空间关系以及不同脑功能区域之间的功能连接。

为了研究功能区域内和功能区域之间的大脑活动,研究团队提出了一种自适应局部全局图表示网络(ALGGNet)。相关研究成果以“ALGGNet: An Adaptive Local-Global-Graph Representation Network for Brain-Computer Interfaces”为题,发表在人工智能领域知名期刊《Knowledge-Based Systems》(IF 7.2,中国科学院一区,Top期刊)上。

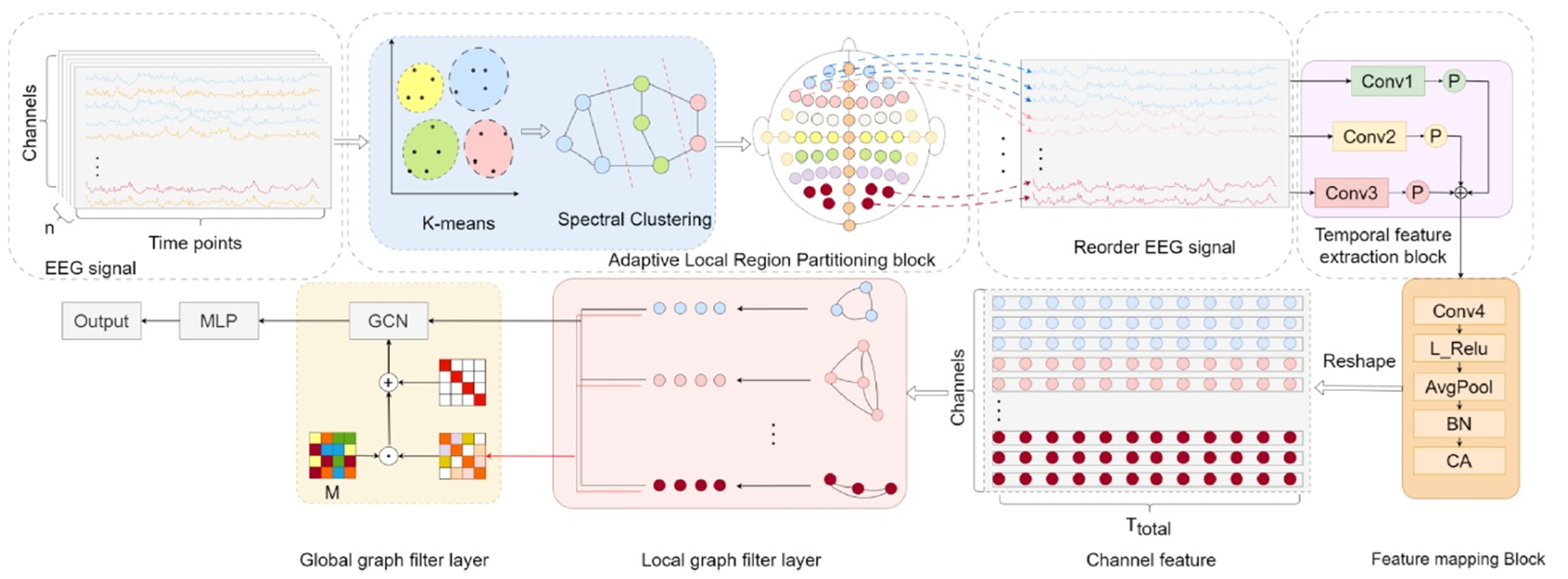

ALGGNet网络由三个基本组件组成:自适应局部区域划分块、时间学习块和图学习块。首先采用神经科学中的脑功能区概念,并采用双聚类算法自适应地为特定数据集生成类脑功能区。然后根据聚类结果对EEG通道进行重新排序。随后,EEG信号通过时间信息处理阶段和图学习阶段。时间信息处理阶段主要包括多尺度时间卷积块和具有坐标注意力机制的特征映射块。图学习阶段包括聚集关于局部区域的信息的图过滤器和学习局部区域之间复杂关系的全局图卷积网络。该网络适用于脑机接口应用,包括运动图像脑电图信号的解码和情绪识别。

论文链接:https://www.sciencedirect.com/science/article/abs/pii/S0950705125001431

EEG和功能性近红外光谱(fNIRS)信号融合可弥补单一模态的不足,全面反映大脑活动模式。然而两者在物理本质、采样频率和噪声特性上差异显著,这给融合带来挑战。如何有效融合这两种信号,保留各自优势,是当前亟待解决的问题。

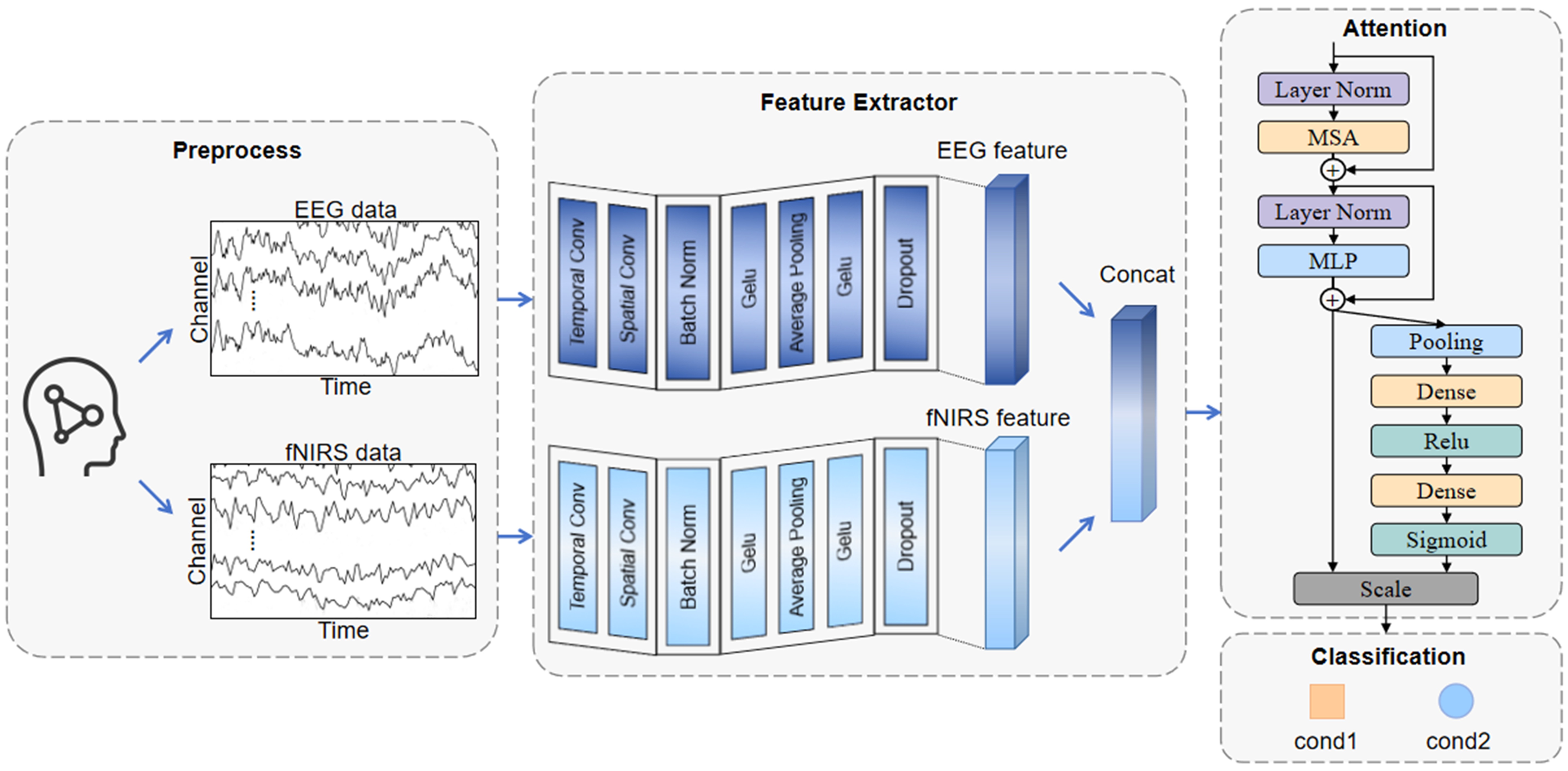

为了研究如何通过融合信号提高分类效率,研究团队提出了一种融合时空卷积和注意力机制的网络(ST2A)。相关研究成果以“Fusion analysis of EEG-fNIRS multimodal brain signals: a multitask classification algorithm incorporating spatial-temporal convolution and dual attention mechanisms”为题,发表在工程技术领域知名期刊《IEEE Transactions on Instrumentation and Measurement》(IF 5.6,中国科学院二区,Top期刊)上。

ST2A网络由三个基础部分组成:信号预处理模块、特征提取模块和注意力计算模块。首先是对两种信号的预处理,保留EEG和fNIRS信号的关键部分,转换成可以输入进神经网络的特征形式并将信号对齐。然后分别对EEG和fNIRS信号进行时空特征提取,得到两个信号的高级特征,并进行顺序拼接。再利用Transformer编码器和SE模块进行双重注意力计算。实验结果表明所提出的网络获得了最先进的性能,也证明了该网络在信号融合领域的通用性。

论文链接:https://ieeexplore.ieee.org/document/10886982

在所有脑机接口范式中,运动想象(MI)允许用户通过想象运动而不是实际执行动作来控制外部设备。EEG信号和fNIRS信号是从大脑获取MI信号的两种更流行的神经成像技术。然而,由于EEG或fNIRS的局限性,基于MI的单模态信号分类方法的性能较低。

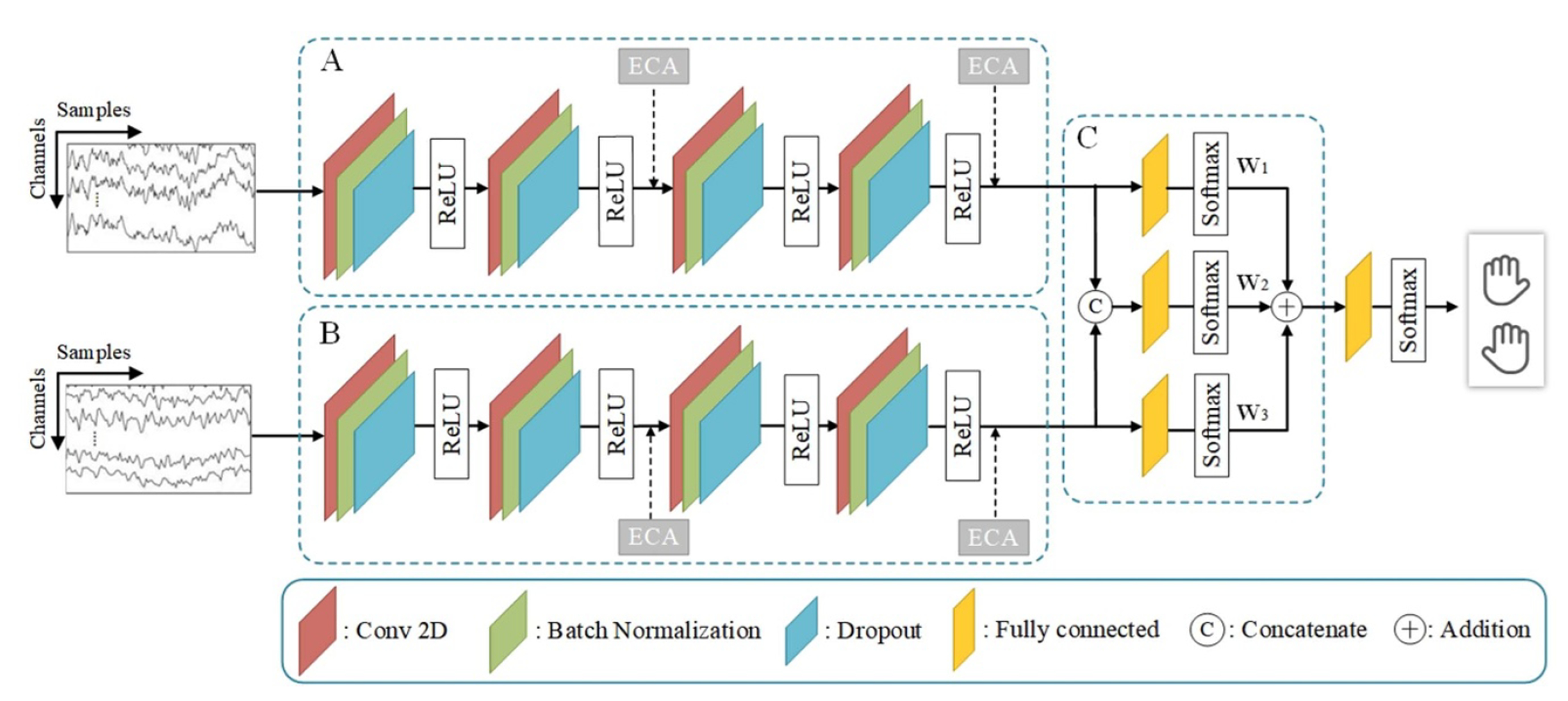

为了解决单模态信号分类和多模态信号融合分类的性能不佳的问题,研究团队提出了一种混合EEG-fNIRS信号的ECA-FusionNet分类网络。相关研究成果以“ECA-FusionNet: A hybrid EEG-fNIRS signals network for MI classification”为题,发表在工程技术领域知名期刊《Journal of Neural Engineering》(IF 3.7,中国科学院三区)上。

ECA-FusionNet分类网络能够结合EEG和fNIRS潜在的互补优势。采用特征提取网络从基于EEG和fNIRS的MI信号中提取时空特征;在特征层和决策层先后融合了EEG和fNIRS,以提高模型的适应性和鲁棒性。该研究成果为多模态信号融合分类领域提供有益的参考。

论文链接:https://iopscience.iop.org/article/10.1088/1741-2552/adaf58

(供稿:电气学院)